关于yolov8移动端部署实现结合目标检测与手指跟踪并发出声音告警

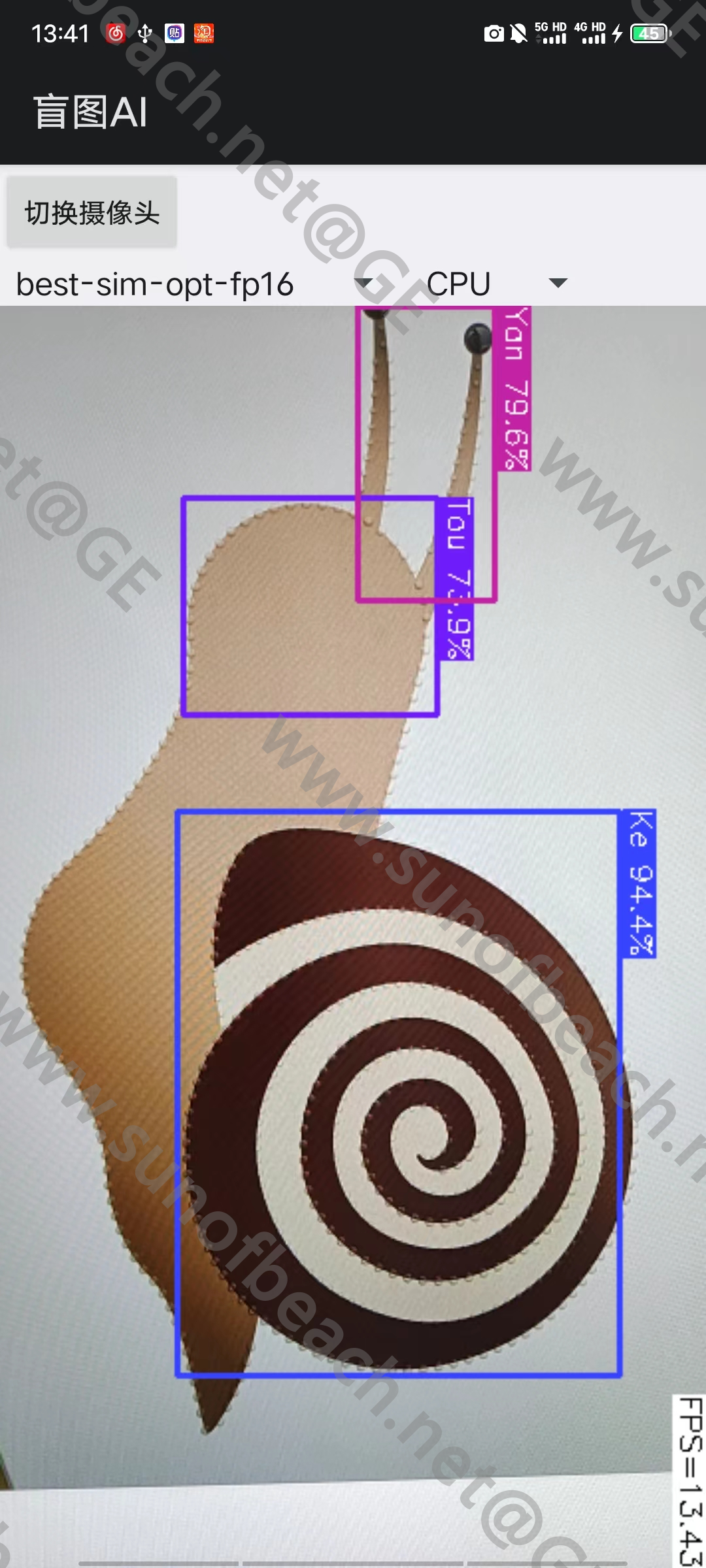

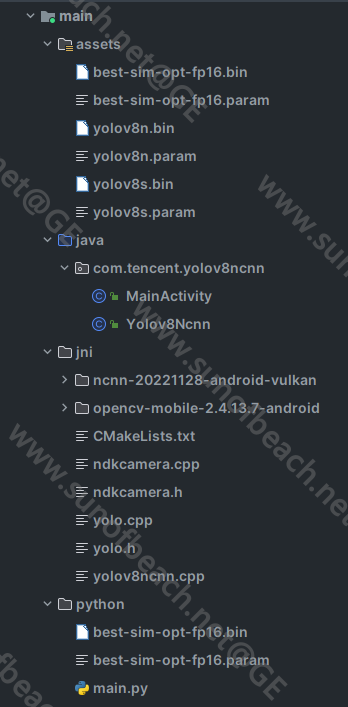

最近有个项目需求是通过部署自己训练的yolov8移动端模型实现目标检测,同时结合手指跟踪,当手指处于检测框内发出声音告警提示。例如:当手指指向蜗牛头部时发出头部的语音提示。目前模型实现了目标检测,即头部,壳,触角等检测。当在做移动端的手指跟踪和声音告警的时候没有思路了。在pc端倒是可以通过python代码实现了手指跟踪和声音告警,但是如何在移动端实现呢?目标部署到移动端用的是ncnn模型,我初步的思路是想通过python和Android交互去实现手指跟踪和声音告警,但是发现这种思路好像不太行得通,有做过这方面需求的大佬指点一下吗?

因为篇幅原因,若有需要各个类代码的我可以再提供出来

app演示图:

Android目录文件:

其中assets中前两个best开头的是模型文件

在移动端实现手指跟踪和声音告警,确实需要针对移动设备的特性和SDK进行开发。您的思路中提到通过Python与Android交互并不适合移动端应用,因为Android应用通常使用Java或Kotlin编写,而非Python。以下是一些可行的步骤和思路:

综合以上几点,您需要熟悉Android Native开发,并结合 ncnn 库在原生层完成YOLOv8模型的推理工作,同时在应用层实现手指跟踪和声音反馈功能。确保所有功能模块之间协同工作,形成完整的交互体验。

看看有没有Android的SDK啊

你pc能跑通,那么手机端也应该没问题的。这里难点,就是你手势的目标框是怎么判断指向蜗牛头部,你pc端是怎么判断,再用c或者java代码重写一次。