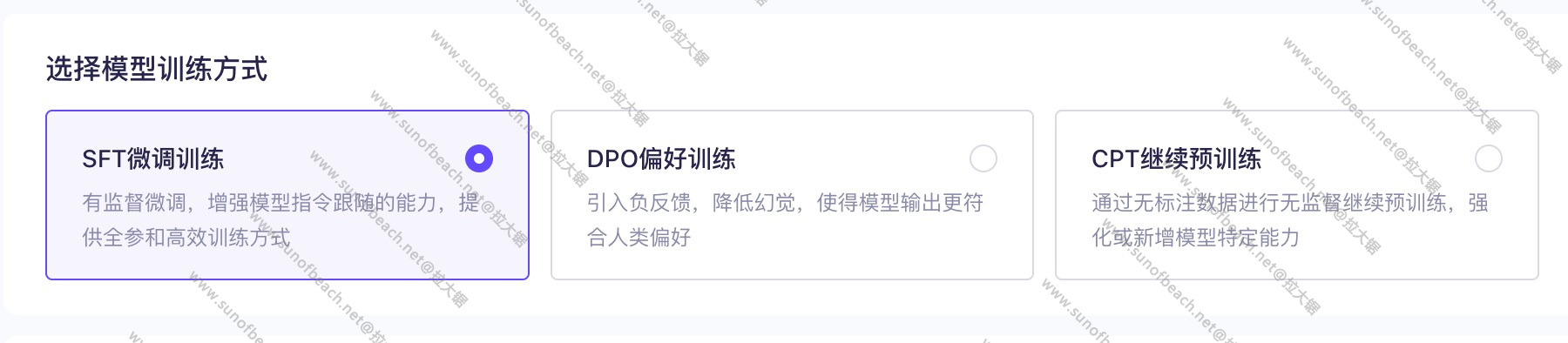

以下是SFT微调训练、DPO偏好训练和CPT继续预训练的解释及对比:

1. SFT(Supervised Fine-Tuning,监督微调)

• 定义:在预训练模型的基础上,使用标注数据(输入-输出对)进行有监督的微调,使模型适应特定任务。 • 数据:需要高质量的标注数据(如问答对、指令-回复对)。 • 目标:最小化模型输出与标注答案之间的损失(如交叉熵)。 • 特点: • 直接学习输入到输出的映射。 • 适用于任务明确、数据规范的场景(如客服对话、文本摘要)。 • 示例:用法律问答数据微调模型,使其生成专业法律回答。

2. DPO(Direct Preference Optimization,直接偏好优化)

• 定义:通过人类偏好数据(如选择“更好”的回答)直接优化模型,无需显式奖励模型。 • 数据:偏好对(同一输入的两个输出,标注哪个更优)。 • 目标:最大化偏好回答的概率,最小化非偏好回答的概率。 • 特点: • 替代RLHF(强化学习人类反馈),更高效稳定。 • 适用于对齐人类价值观或提升回答质量(如创意生成、无害性)。 • 示例:让模型在多个回复中选择更友善或更专业的答案。

3. CPT(Continued Pre-Training,继续预训练)

• 定义:在预训练模型基础上,用领域通用数据继续无监督训练,增强模型的基础能力。 • 数据:大规模无标注文本(如医学文献、代码库)。 • 目标:通过自监督学习(如掩码语言建模)更新模型参数。 • 特点: • 不针对具体任务,而是提升领域泛化能力。 • 计算成本高,需大量数据和资源。 • 示例:在通用模型上用生物医学文本继续预训练,提升医学理解能力。

三者的核心区别

| 方法 | 数据需求 | 训练目标 | 适用场景 |

|---|---|---|---|

| SFT | 标注输入-输出对 | 拟合标注答案 | 任务明确的场景(如翻译、分类) |

| DPO | 人类偏好对 | 对齐人类偏好 | 提升回答质量或安全性(如聊天机器人) |

| CPT | 无标注文本 | 自监督学习(如掩码预测) | 领域适应(如金融、法律预训练) |

如何选择?

• 任务明确 → 用SFT微调。 • 需对齐人类偏好 → 用DPO或RLHF。 • 领域迁移(如从通用到医学) → 用CPT增强基础能力。

实际应用中,可组合使用(如CPT→SFT→DPO)。